Internet de las cosas

El Internet de las cosas (IoT) es el proceso que permite conectar los elementos físicos cotidianos al Internet: desde los objetos domésticos comunes, como las bombillas de luz, hasta los recursos para la atención de la salud, como los dispositivos médicos; las prendas y los accesorios personales inteligentes; e incluso los sistemas de las ciudades inteligentes.

Los dispositivos del IoT que se encuentran dentro de esos objetos físicos suelen pertenecer a una de estas dos categorías: son interruptores (es decir, envían las instrucciones a un objeto) o son sensores (recopilan los datos y los envían a otro lugar).

Funcionamiento del IoT

El término IoT hace referencia a los sistemas de dispositivos físicos que reciben y transfieren datos a través de las redes inalámbricas, con poca intervención humana. Es posible gracias a la integración de dispositivos informáticos en todo tipo de objetos.

Por ejemplo, un termostato inteligente (es decir, que utiliza el IoT) recibe los datos de la ubicación de su automóvil inteligente, y ambos dispositivos conectados le permiten ajustar la temperatura de su casa a pesar de que no se encuentre allí.

El funcionamiento de los sistemas de IoT tradicionales consiste en enviar, recibir y analizar los datos de forma permanente en un ciclo de retroalimentación. Según el tipo de tecnología de IoT, las personas o los sistemas de inteligencia artificial y aprendizaje automático (IA/ML) pueden analizar estos datos casi de inmediato o durante cierto tiempo.

Por ejemplo, para saber cuándo es ideal controlar el termostato antes de volver a casa, el sistema de IoT puede conectarse a la API de Google Maps y, de este modo, obtener información actual sobre el tráfico en el área. Además, puede utilizar los datos a largo plazo del automóvil para conocer sus hábitos de conducción. Por otra parte, las empresas de servicios públicos tienen la posibilidad de analizar los datos de IoT de los clientes con termostatos inteligentes para optimizar el sistema en general.

IoT Empresarial

Por lo general, el IoT capta la atención de los consumidores, cuyas experiencias con las tecnologías, como los relojes inteligentes, se ven afectadas por las preocupaciones en torno a la seguridad y la privacidad que supone el hecho de estar conectados de forma permanente. Esta perspectiva se aplica a todos los tipos de proyectos de IoT empresarial, especialmente cuando el usuario final es el público en general.

Las soluciones de IoT para las empresas les permiten mejorar los modelos comerciales actuales y entablar nuevas relaciones con los clientes y los partners, pero también implican ciertos desafíos. El volumen de datos que genera un sistema de dispositivos inteligentes (lo cual se conoce como big data) puede ser abrumador. El proceso de integración del big data en los sistemas actuales y la configuración del análisis de los datos para poder utilizar la información puede resultar complicado.

La seguridad es un aspecto muy importante que se debe considerar durante el diseño de los sistemas de IoT. Aun así, para muchas empresas vale la pena hacer el esfuerzo: hay casos prácticos exitosos en casi todos los sectores.

¿Qué es el Big Data?

El término “big data” abarca datos que contienen una mayor variedad y que se presentan en volúmenes crecientes y a una velocidad superior. Esto también se conoce como “las tres V”.

Dicho de otro modo, el big data está formado por conjuntos de datos de mayor tamaño y más complejos, especialmente procedentes de nuevas fuentes de datos. Estos conjuntos de datos son tan voluminosos que el software de procesamiento de datos convencional sencillamente no puede gestionarlos. Sin embargo, estos volúmenes masivos de datos pueden utilizarse para abordar problemas empresariales que antes no hubiera sido posible solucionar.

Comentario personal

Según las definiciones presentadas sobre lo que es el Big Data y el IoT (Internet of Things) extraídas de páginas con renombre en el mundo de la tecnología como lo es Oracle y Red Hat, puedo entender estos 2 términos:

IoT:

Es una tendencia que se basa en la recolección de información de ciertos dispositivos a través de internet, con le fin de analizar a la población que hace uso de dispositivos que recolectan la información. Esta tendencia en mi opinión me gusta y me intriga, de hecho hago parte del movimiento ya que en la mayoría de sitios webs, apps, dispositivos, etc. Que se puede recolectar información, yo lo permito y lo consiento (siempre y cuando no sea información MUY personal y delicada) porque confío en que ese tipo de estadísticas serán usadas para el bien común, es decir, en la mejoría de servicios tanto para el cliente como para el dueño, aunque han habido varias pruebas de que hay ciertas empresas que utilizan la información de usuarios de manera ilícita y con fines lucrativos vendiendo dicha información a terceros sin el consentimiento de los usuarios y no hay que perder de vista que esta situación también tiene que ver con la ciberseguridad que claramente es un campo que está intrínsicamente involucrado en el trabajo del manejo y recolección de datos.

Big Data:

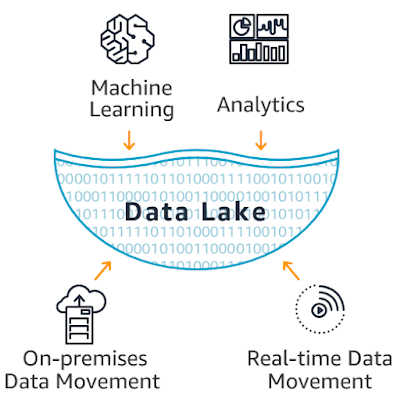

El Big Data, como su nombre lo indica, es el manejo de gran cantidad de información. Hoy en día los dispositivos tecnológicos que una persona manipula en su día a día recolectan una gran cantidad de información valiosa para las empresas cuando se trata de predecir, analizar o descubrir y a partir de ahí es que decimos que hay big data. Para poder trabajar de manera exitosa con esta gran cantidad de información no lo podemos hacer con las técnicas tradicionales, por eso es que nacen nuevas técnicas y métodos junto con nuevas tecnologías diseñadas específicamente y especialmente para un trabajo de Big Data, que es un proceso ETL (Extracción, Transformación y Carga [Load en inglés]).

Desde mi punto de vista, logro identificar que el Big Data y el Iot van de la mano porque como vimos antes, en los 2 procesos hay grandes cantidades de información, uno las emite (IoT) y el otro se carga de hacer un trabajo con ellos (Big Data). Cabe resaltar que todos estos datos por si mismos no son nada, hay que leerlos, entenderlos, organizarlos y limpiarlos para poder dar una posible respuesta a un problema que se está presentando en nuestra organización.